文章来源:08AI导航网发布时间:2025-04-09 15:38:42

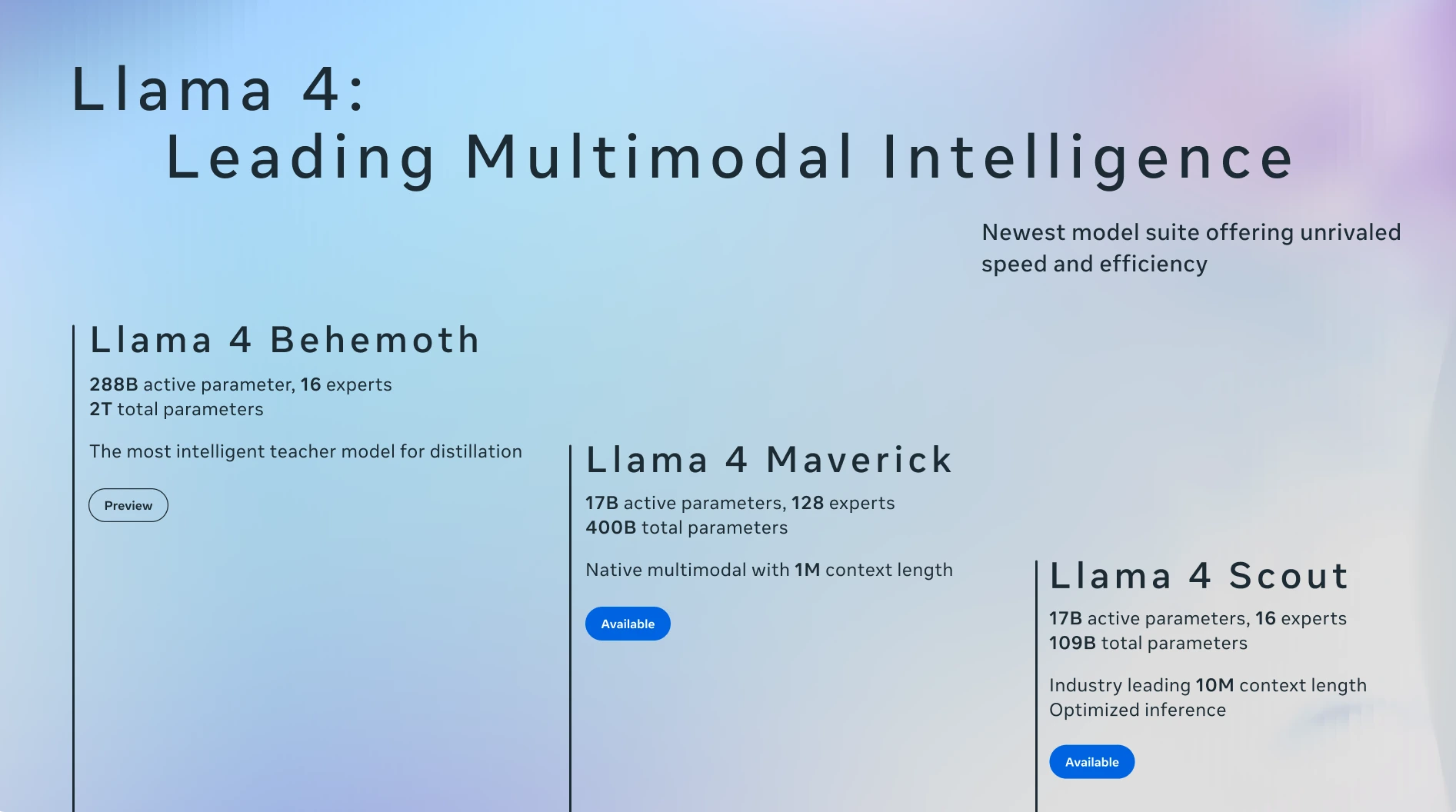

Llama 4 是 Meta 公司于 2025年4月5日发布的最新一代开源ai模型系列。包括Llama 4 Scout和Llama 4 Maverick,它们是首批采用混合专家(MoE)架构的多模态AI模型。Scout 拥有 170 亿个活跃参数、16个“专家”模型、总参数量为1090亿,而 Maverick 同样有170亿个活跃参数,但配备了 128 个“专家”模型,总参数量高达4000亿。此外,还有一个正在开发中的更强大的版本Llama 4 Behemoth,它有2880亿个活跃参数、16个“专家”模型,总参数量接近2万亿。这些模型经过大量未标注的文本、图像和视频数据训练,具备视觉理解能力。

参数规模:170 亿活跃参数,16 个专家

硬件需求:可在单张 NVIDIA H100 GPU 上运行

上下文窗口:支持高达 1000 万个 token 的超长上下文窗口

性能优势:优于 Gemma 3、Gemini 2.0 Flash-Lite 和 Mistral 3.1

参数规模:170 亿活跃参数,128 个专家,总参数量 4000 亿

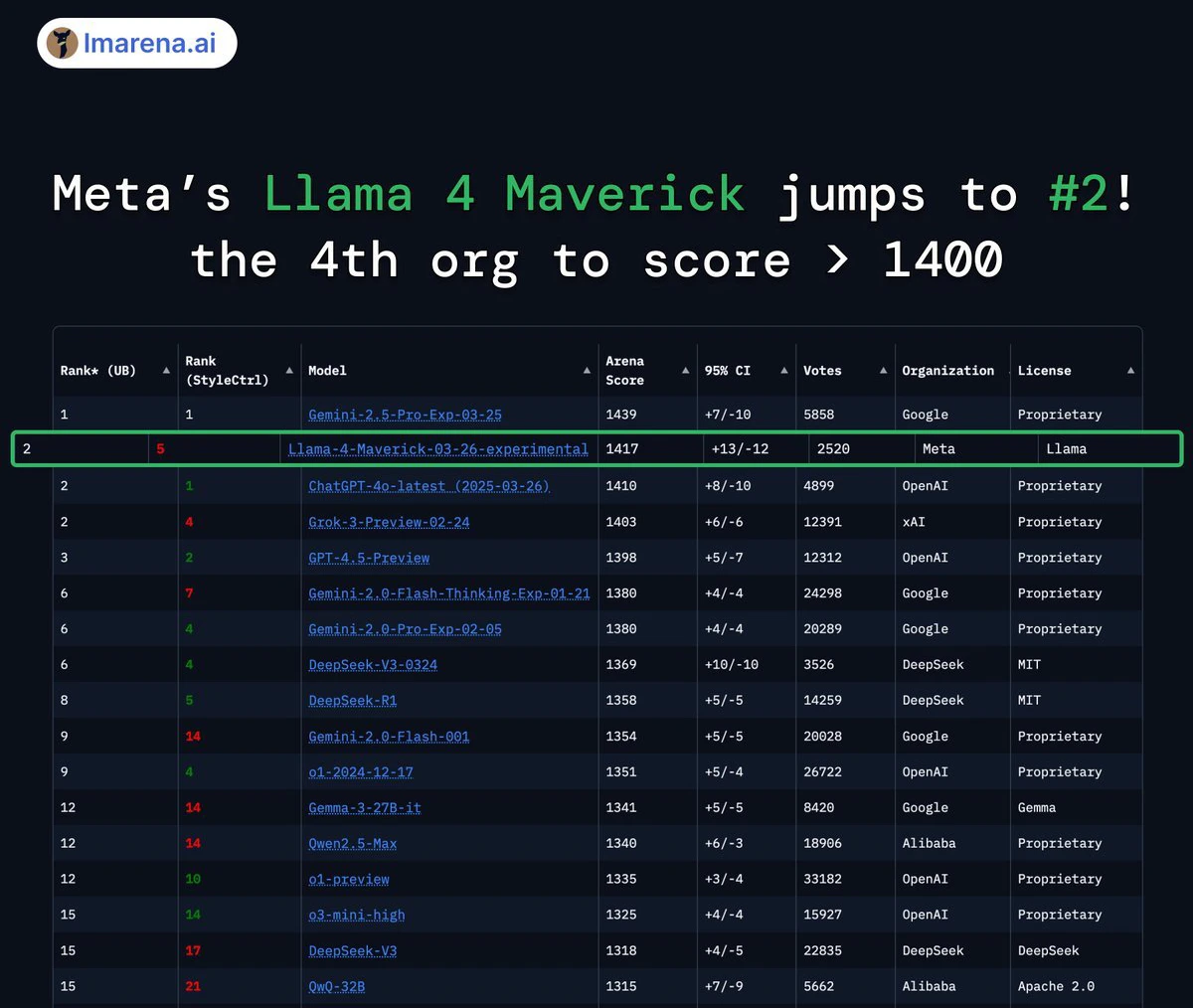

性能优势:在多模态任务中表现卓越,性能超过 GPT-4o 和 Gemini 2.0 Flash

推理能力:推理和编程能力与 DeepSeek v3 相当,但活跃参数不到其一半

参数规模:2880 亿活跃参数,16 个专家,总参数量接近 2 万亿

性能优势:在多个 STEM 基准测试中,性能超过 GPT-4.5、Claude Sonnet 3.7 和 Gemini 2.0 Pro

角色定位:作为教师模型用于蒸馏其他 Llama 4 模型,目前仍在训练中

多模态能力:Llama 4 是一个多模态大模型,能够处理和整合文本、视频、图像和音频等不同类型的数据,并在这些格式之间转换内容。例如,Llama 4 Scout 可以在复杂环境中分析图像内容。

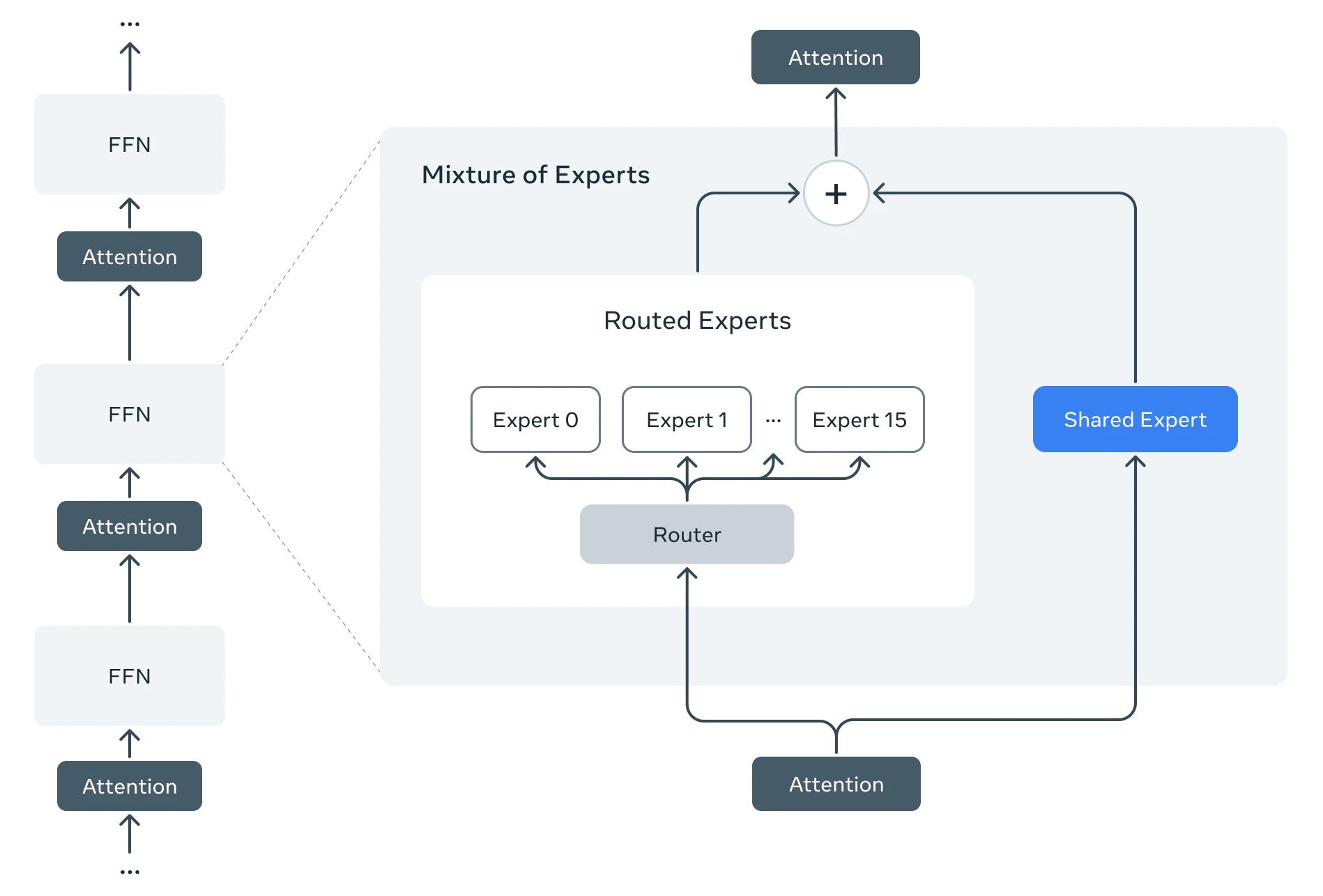

混合专家架构:这是 Llama 4 的核心特点之一。该架构将模型划分为多个专注于特定任务的“专家”子模型,从而提高训练和回答用户查询时的效率。例如,Llama 4 Maverick 模型总共有 4000 亿个参数,但仅有 170 亿个参数在实际运算中活跃。

长上下文处理能力:Llama 4 Scout 的上下文窗口可达到 1000 万个词元,这使得它在处理冗长文档时表现尤为优异。

语音功能:Llama 4 引入了原生语音处理功能,能够直接处理语音信息,无需先将语音转换为文本再输入模型处理,最后又将文本转换回语音。这极大地提升了语音交互的效率和流畅度。

客户服务:企业可以使用这种多模态 AI 模型快速分析用户提出的问题,提供更加准确和高效的答复。

教育领域:智能教学助手可以通过理解学生的提问和辅以图像的方式来解释复杂概念,极大提升学习效果。

虚拟会议:在虚拟会议中,Llama 4 能够充当助手,帮助用户进行实时翻译、记录会议要点,甚至还可以模拟参与者的发言,提高沟通效率。

智能设备控制:用户通过语音指令,可轻松完成撰写文本、发送信息、控制智能家居设备等任务。

信息密集型领域:Llama 4 的长上下文处理能力使其在医学、科学、工程、数学、文学等信息密集型领域非常实用。

模型规模和参数数量:Llama 4 Scout 拥有 170 亿个活跃参数、16 个“专家”模型、总参数量为 1090 亿;Llama 4 Maverick 同样有 170 亿个活跃参数,但配备了 128 个“专家”模型,总参数量高达 4000 亿;Llama 4 Behemoth 则拥有 2880 亿个活跃参数和 2 万亿个总参数。

训练数据和多样性:所有模型都经过了大量未标注的文本、图像和视频数据的训练,以获得广泛的视觉理解能力。

架构优化:采用了混合专家架构,通过将数据处理任务分解为子任务,并将其分配给更小的“专家”模型,实现了更高的运行效率。

推理效率:通过降低模型运行成本和延迟,提高了推理效率。例如,Llama 4 Maverick 可以在单个英伟达 H100 DGX 主机上运行。

Meta 估计Llama 4 Maverick 的推理成本为每 100 万个 tokens 0.19 美元至 0.49 美元(输入和输出比例为 3:1),这使得它比像 GPT-4o 这样的专有模型便宜得多。

详细阅读:https://ai.meta.com/blog/llama-4-multimodal-intelligence/

模型下载:https://www.llama.com/llama-downloads/?utm_source=llama-home-hero&utm_medium=llama-referral&utm_campaign=llama-utm&utm_offering=llama-downloads&utm_product=llama

相关攻略 更多

最新资讯 更多

AI眼镜 “百镜大战” 打响!小小米眼镜官方微博上线引发市场热潮,产业链有望迎来快速发展期

更新时间:2025-04-19

新春第一课!自治区科协举办人工智能科普报告会

更新时间:2025-04-19

加速人工智能赛道布局!东莞市政府高规格召开新春第一场新闻发布会

更新时间:2025-04-19

东莞2025年“一号文”发布 聚焦“人工智能+先进制造”

更新时间:2025-04-19

马斯克:无人机和人工智能将主导未来战争 美国要加大投资

更新时间:2025-04-19

法国印度将联合主持AI行动峰会

更新时间:2025-04-19

法印将联合主持AI行动峰会,法媒:法欧希望借此峰会确立自身竞争地位

更新时间:2025-04-18

OpenAI前高管创立的AI公司据称洽谈融资 估值或达200亿美元

更新时间:2025-04-18

谷歌放弃 “不开发武器 AI” 承诺引争议,吴恩达表态支持

更新时间:2025-04-18

外交部:欢迎各国来华出席2025世界人工智能大会

更新时间:2025-04-18