文章来源:万象ai发布时间:2025-04-05 11:24:50

AI奇点网6月8日报道 |AI模型的计算成本

生成式AI模型的推理和训练成本取决于模型的大小和类型。大部分流行的模型采用了基于transformer架构的设计,例如GPT-3、GPT-J和BERT等。尽管transformer的具体推理和训练操作数量是特定于每个模型的,但可以通过一个相对准确的经验法则来估算,该法则仅取决于模型的参数数量、输入和输出令牌的数量。

令牌是短序列,通常对应于单词或单词的一部分。通过使用在线令牌生成器,可以很好地了解令牌的概念。以GPT-3为例,平均令牌长度为4个字符。

对于具有p个输入参数和每个长度为n个标记的输出序列的模型,前向传递(推理)大约需要2np浮点运算(FLOPs)¹。同一模型的训练每个标记大约需要6*p FLOPs(即,额外的向后传递需要另外四次操作²)。通过将此乘以训练数据中的标记数量,可以估算出总训练成本。

此外,transformer的内存要求也取决于模型的大小。对于推理,需要p个模型参数来适应内存。而对于训练,需要为每个参数存储额外的中间值。通过使用更短的浮点数,如16位浮点数,可以优化推理和训练的内存需求。

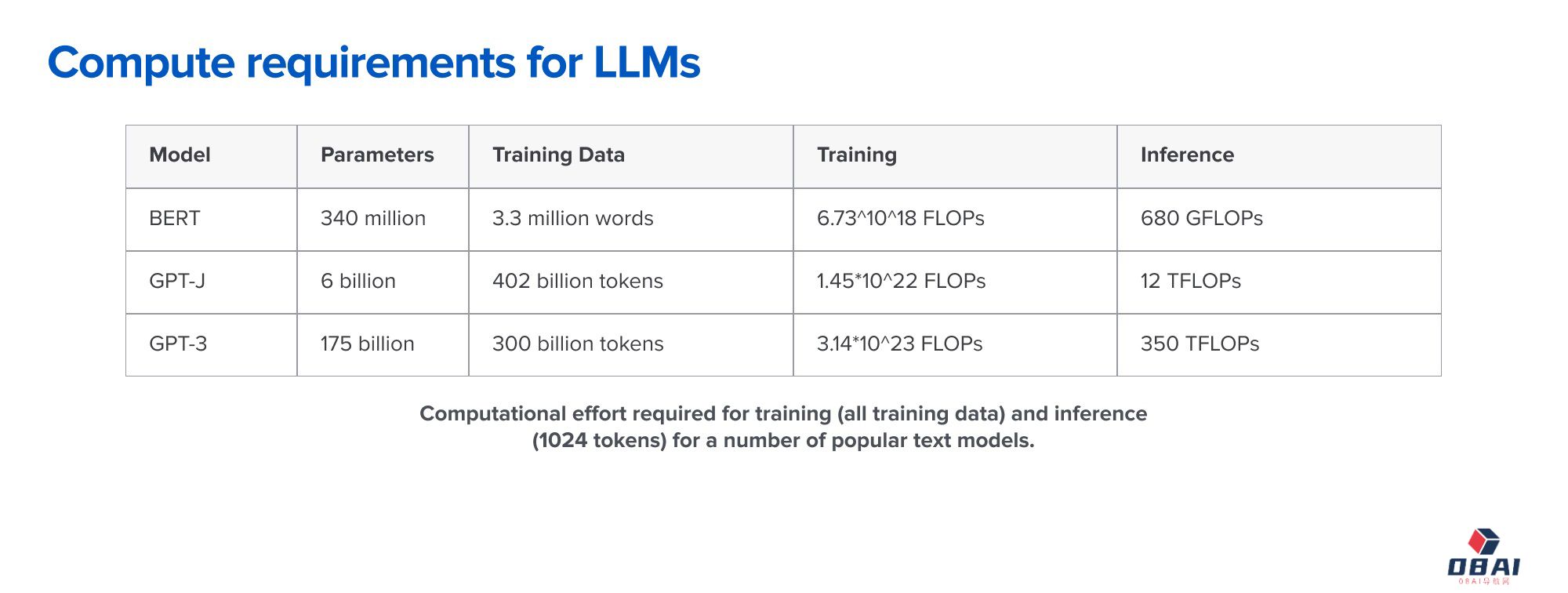

以下是几种流行模型的大小和计算成本示例。以GPT-3为例,它具有约1750亿个参数,对于输入和输出的1024个令牌,计算成本约为350万亿次浮点运算(即Teraflops或TFLOPs)。像GPT-3这样的模型的训练大约需要3.14*10^23次浮点运算。

计算资源挑战与优化

AI基础设施非常昂贵,因为底层算法问题在计算上非常困难。与使用GPT-3生成单个单词相比,对拥有数百万条目的数据库进行排序,其复杂性微不足道。在选择模型时,需要选择能够满足用途的最小模型。

好消息是,对于transformer,可以很容易地估计特定大小的模型将消耗多少计算和内存资源。因此,在选择硬件时,需要仔细考虑。

AI公司面临的计算资源挑战以及计算成本高的原因。AI模型的计算成本取决于模型的大小和类型,而生成式AI模型的推理和训练成本是关键因素。了解这些挑战和优化策略有助于更好地理解AI领域的计算资源问题,并为AI公司的发展提供指导。

相关攻略 更多

OpenAI底层AGI技术被曝光!前研究主管豪言:从此再无新范式

爆款AI视频越来越多,但本质我觉得跟炒股没区别。

Cursor+Claude的SVG图片生成功能,强到离谱,强烈建议写PPT没思路的时候买个会员

超20万人使用!最强开源浏览器Workflow插件【内置3300+模版】效率又起飞了~

营销获客AI公司Clay,花7年找到PMF后,快速实现10倍增长的秘密

5天连发5个王炸!MiniMax这波发布周把OpenAI都整懵了|MiniMax发布周回顾

AI应用行业全景洞察丨中国丨2025年5月丨万字诚作丨Xsignal

数字疗法AI医疗独角兽SwordHealth再融4000万,估值冲至40亿美元背后的战略棋局

最新资讯 更多

OpenAI底层AGI技术被曝光!前研究主管豪言:从此再无新范式

更新时间:2025-07-25

爆款AI视频越来越多,但本质我觉得跟炒股没区别。

更新时间:2025-07-25

Cursor+Claude的SVG图片生成功能,强到离谱,强烈建议写PPT没思路的时候买个会员

更新时间:2025-07-25

超20万人使用!最强开源浏览器Workflow插件【内置3300+模版】效率又起飞了~

更新时间:2025-07-25

营销获客AI公司Clay,花7年找到PMF后,快速实现10倍增长的秘密

更新时间:2025-07-25

5天连发5个王炸!MiniMax这波发布周把OpenAI都整懵了|MiniMax发布周回顾

更新时间:2025-07-25

AI应用行业全景洞察丨中国丨2025年5月丨万字诚作丨Xsignal

更新时间:2025-07-25

数字疗法AI医疗独角兽SwordHealth再融4000万,估值冲至40亿美元背后的战略棋局

更新时间:2025-07-25

宁德时代领投,「银河通用」完成超10亿元新一轮融资

更新时间:2025-07-25

【译】万字长文解读:生成式AI的21个设计模式、示例及应用策略

更新时间:2025-07-25